- Liittynyt

- 14.10.2016

- Viestejä

- 24 520

NVIDIAn G-Sync-teknologia tuo mukanaan ylimääräisiä kustannuksia näyttöjen valmistajille, mikä näkyy loppukäyttäjille vastaavia FreeSync- eli Adaptive-sync-näyttöjä kalliimpina hintoina. Monet ovat kiristelleet hampaita NVIDIAn jatkaessa standardia vastaan taistelua, mutta nyt survfate-nimimerkkiä käyttävä Reddit-käyttäjä on löytänyt tavan saada FreeSync toimimaan myös NVIDIAn näytönohjaimilla.

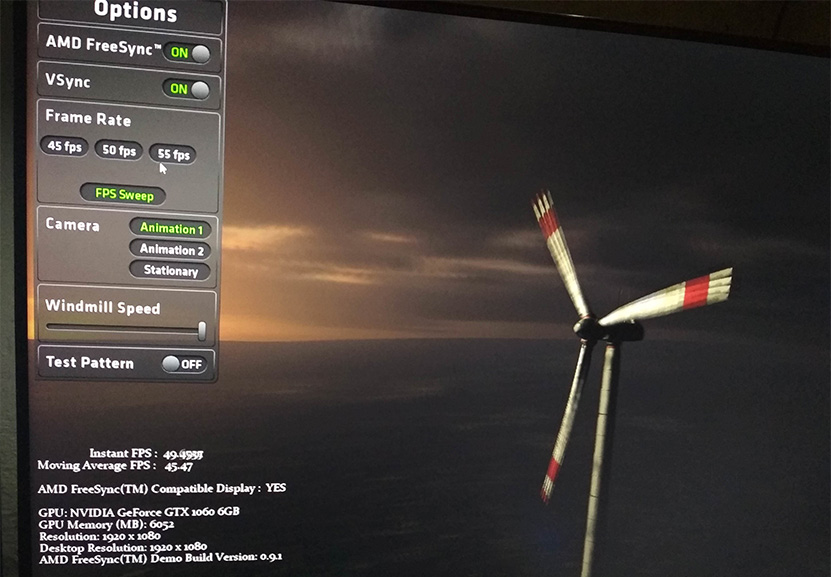

Survfate on saanut kikkailemalla Windowsin uusilla GPU-asetuksilla FreeSyncin toimimaan NVIDIAn GeForce GTX 1060 6 Gt -näytönohjaimella. Periaatteessa minkä tahansa NVIDIAn näytönohjaimen pitäisi kuitenkin toimia täysin samoin. Millä tahansa kokoonpanolla homma ei kuitenkaan toimi, vaan se vaatii näillä näkymin AMD:n APU-piirin kokoonpanon prosessoriksi.

Saadakseen FreeSyncin toimimaan NVIDIAn näytönohjaimella täytyy järjestelmän ensisijaiseksi näytönohjaimeksi valita AMD:n integroitu grafiikkaohjain ja kytkeä FreeSync-näyttö emolevyn liitäntään. FreeSync-näyttö on myös asennettava ykkösnäytöksi, mikäli kokoonpanossa on useampi näyttö.

Käyttäjän on asennettava ajurit sekä AMD:n integroidulle näytönohjaimelle että NVIDIAn erillisnäytönohjaimella, jonka jälkeen Radeon Settings -asetuksista asetetaan FreeSync käyttöön ja NVIDIAn ohjauspaneelista puolestaan valitaan käytettäväksi näytönohjaimeksi GeForce. Myös Windows 10:n versio 1803:n eli viime kevään päivityksen sisäänrakennetun näytönohjainvalitsimen pitäisi ajaa sama asia.

Tämän jälkeen minkä tahansa FreeSync-näytöllä pyörivän sisällön renderöinnin pitäisi hoitua GeForcella, joka lähettää kuvan AMD:n APU-piirin läpi näytölle. APU-piirin grafiikkaohjain pitää puolestaan huolen ruudunpäivitysnopeuden ja näytön virkistystaajuuden synkronoinnista.

Teoriassa myös AMD:n erillisnäytönohjainten käyttö saattaisi toimia, mutta tätä ei ole ilmeisesti kukaan ehtinyt vielä testaamaan. Ongelmaksi saattaisi muodostua se, että yllä kuvatussa skenaariossa NVIDIAn erillisnäytönohjain toimii kannettavista tutussa Optimus-tilassa, mikä on suunniteltu nimenomaan käyttämään integroitua grafiikkaohjainta näyttöohjaimena.

Päivitys 29.8:

Sama temppu toimii myös AMD:n erillisnäytönohjainten avulla.

Lähde: Reddit

Huom! Foorumiviestistä saattaa puuttua kuvagalleria tai upotettu video.

Linkki alkuperäiseen uutiseen (io-tech.fi)

Palautelomake: Raportoi kirjoitusvirheestä

Viimeksi muokattu: