-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset Black Friday 2025 -tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

-

Hyvää joulua!

Osallistu io-techin piparikakkutalokilpailuun 2025 Linkki osallistumisketjuun >>>

SER-huutokaupat hyväntekeväisyyteen käynnissä! Linkki huutokauppaan >>>

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA-spekulaatioketju (Blackwell ja tulevat sukupolvet)

Fe on nvidian oma design ja AIb on nvidian partnerikortit virallinen termi ollut tämä.

msi,asus,galax,colorful,manli,evga,gigabyte on AIB partnerit.

ps. palit ja kfa myös ja unohtu gainward.

Jatketaan nyt vielä tätä Off Topicia: Niin, siis se on väärin käytetty nimitys toki. Nuo AIB partnerit valmistavat tietenkin myös FE-kortteja, minkä takia AIB:n väittäminen viralliseksi termiksi ei olekaan enää niin virallinen, vaan ainostaan se tavallisesti väärin käytetty termi.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 637

Sinänsä DLSS:n kanssa riittäisi kun kaikki isoimmat (=raskaimmat) pelit olisi tuettuna, eli ei tarvitse jokaista kymmenestä tuhanneista vuosittain julkaistusta indiestä tukea. Harmittavasti tuo isoimmat pelit tuettuna on vielä kaukana todellisuudesta eikä siihen varmaan päästä. Jo pelkästään AMD sponsoroi vuosittain aina useampaa isoa julkaisua ja näihin tuskin kovin tasaisesti DLSS tukea tulee.

Hyviä pointteja. Sekä DLSS:n että RT:n tulevaisuuden kannalta tuo pelituki on yksi suurimpia kysymysmerkkejä. Nvidia tehnyt hyvää työtä ja antaa varmasti kaikki työkalut pelistudioille, mutta ei Nvidia voi sponsoroida kaikkia isoja pelifirmoja. Eikös toistaiseksi DLSS ole ollut vain ''Nvidia gameworks'' -leimalla varustetuissa peleissä?

Tuo DLSS ei mulle muutenkaan aivan täysin aukea. Eikö pointti ole käytännössä saada isot resoluutiot ''vähemmillä tehoilla''? Nyt kuitenkin Nvidia tuo pirun tehokkaita näytönohjaimia, joilla varmaan natiivi 4K hyvillä FPS:llä varmaan realismia? Kai tuo DLSS paljon muutakin sisältää, ja linkittyy jotenkin säteenseurantaan. Pitää jatkaa nettiopiskelua.

Tuo DLSS ei mulle muutenkaan aivan täysin aukea. Eikö pointti ole käytännössä saada isot resoluutiot ''vähemmillä tehoilla''? Nyt kuitenkin Nvidia tuo pirun tehokkaita näytönohjaimia, joilla varmaan natiivi 4K hyvillä FPS:llä varmaan realismia? Kai tuo DLSS paljon muutakin sisältää, ja linkittyy jotenkin säteenseurantaan. Pitää jatkaa nettiopiskelua.

Kaipa ajatuksena on, että pelit voivat näyttää entistä paremmilta 4K:ssa ja FPS pysyy silti hyvänä näillä uusilla näytönohjaimilla. "Natiivi 4K" Minecraftissa ja jossain Cyberpunk 2077:ssa on vähän eri asia suorituskyvyn kannalta.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 533

DLSS tarkoittaa matalammalla resoluutiolla renderöintiä ja skaalaamista korkeammalle resoluutiolle tekoälyverkon avulla hyödyntäen paria viimeistä framea ja niiden tietoja, jotta lopputulos muistuttaisi mahdollisimman lähelle natiivia. Tekoälyverkon pohjana on malli mille on opetettu "perustotuuksia" mitkä on renderöity selvästi korkeammalla resoluutiolla ja "täydellisellä reunojenpehmennyksellä". Ei liity säteenseurantaan mitenkään, aiheuttaa kuvaan artifakteja mitkä ovat joillekin isompi ongelma, toisille ei ongelma lainkaan.Tuo DLSS ei mulle muutenkaan aivan täysin aukea. Eikö pointti ole käytännössä saada isot resoluutiot ''vähemmillä tehoilla''? Nyt kuitenkin Nvidia tuo pirun tehokkaita näytönohjaimia, joilla varmaan natiivi 4K hyvillä FPS:llä varmaan realismia? Kai tuo DLSS paljon muutakin sisältää, ja linkittyy jotenkin säteenseurantaan. Pitää jatkaa nettiopiskelua.

Jep, FE:n testit tulee 14. päivä ja customeiden sitten 17. päivä.Onneksi itsellä ei ole kiire myydä 2080ti halvalla

Olikos se vain FE versiot, joiden arvostelut tulee 14pv?

- Liittynyt

- 08.08.2019

- Viestejä

- 2 637

DLSS tarkoittaa matalammalla resoluutiolla renderöintiä ja skaalaamista korkeammalle resoluutiolle tekoälyverkon avulla hyödyntäen paria viimeistä framea ja niiden tietoja, jotta lopputulos muistuttaisi mahdollisimman lähelle natiivia. Tekoälyverkon pohjana on malli mille on opetettu "perustotuuksia" mitkä on renderöity selvästi korkeammalla resoluutiolla ja "täydellisellä reunojenpehmennyksellä".

Tämä selvä! Jossain Nvidian markkinointi slaidissa oli maininta ''2k rendering up to 8k''. Aika kova potentiaali, mutta oisko toteutus ainoastaan RTX 3090 heiniä. Ja 4k varmaan riittää resoluutiona vielä pitkään.

Kaipa ajatuksena on, että pelit voivat näyttää entistä paremmilta 4K:ssa ja FPS pysyy silti hyvänä näillä uusilla näytönohjaimilla. "Natiivi 4K" Minecraftissa ja jossain Cyberpunk 2077:ssa on vähän eri asia suorituskyvyn kannalta.

Näin olen itsekin kuluttajan näkökulmasta ymmärtänyt. Kun tuon kehittely on aloitettu, niin varmaan Nvidiallekkin joku 4k-natiivi on ollut siinä vaiheessa vielä ''täysin tekemätön paikka''.

Ihan mielenkiintoista olisi nähdä miltä tuo Control esim. näyttää 8k resolla. Tuo 3090 ajetut testit kun on DLSS päällä ja on ihan hivenen harhaanjohtavaa puhua 8k resoluutiosta jos itse peli pyörii 1440p resolla ja sitten se skaalataan 9x kertoimella 8k resoluutioon. Kertoo aika hyvin toki 8k gamingin osalta markkinointitermistä jos 3090 kortilla peli pyörii natiivina 7fps lukemilla.

- Liittynyt

- 21.02.2017

- Viestejä

- 5 991

Natiivi 4k 60fps tulee olemaan Ampereillekin haaste. Esim. RDR2 ja Control ilman säteenseurantaakin jää alle 50fps:n 2080 Ti:llä. Säteenseurannan kanssa Control tippuu alle 30fps:n.Tuo DLSS ei mulle muutenkaan aivan täysin aukea. Eikö pointti ole käytännössä saada isot resoluutiot ''vähemmillä tehoilla''? Nyt kuitenkin Nvidia tuo pirun tehokkaita näytönohjaimia, joilla varmaan natiivi 4K hyvillä FPS:llä varmaan realismia?

DLSS:lle tulee käyttöä ihan 1440p 144hz ja 4K 60hz monitoreillakin, 4k 144hz ja muista huippunäytöistä puhumattakaan.

Hankala keksiä tilannetta interaktiivisen median kanssa missä ottaisin 8k 60fps - 4k 144fps sijasta.

Eiköhän se ole vain markkinointia koska se 8k maininta kääntää päitä ja käytännössä juuri kukaan ei käytä yli 4k resoja. Toki sitten on ultrawidet.

Eiköhän se ole vain markkinointia koska se 8k maininta kääntää päitä ja käytännössä juuri kukaan ei käytä yli 4k resoja. Toki sitten on ultrawidet.

varakreivi de Valmont

cunning linguist

- Liittynyt

- 16.10.2016

- Viestejä

- 1 376

Hankala keksiä tilannetta interaktiivisen median kanssa missä ottaisin 8k 60fps - 4k 144fps sijasta.

Eiköhän se ole vain markkinointia koska se 8k maininta kääntää päitä ja käytännössä juuri kukaan ei käytä yli 4k resoja. Toki sitten on ultrawidet.

Pidän 8K:ta monitoreissa täysin turhana. Sen ainoa tarkoitus on luoda uusi markkinoitava luokka, vaikka käytännön hyödyt niin televisioissa kuin monitoreissa ovat olemattomia.

Tällaisille resoluutioille on silti ihan oikeaakin tarvetta: VR-sovelluksissa. VR-laseilla mikään pikselitiheys ei ole liioittelua, ja DLSS:n kaltaiset suorituskykyoptimoinnit ovat erittäin tärkeitä, jotta päästään tarvittaviin korkeisiin virkistystaajuuksiin.

Btw, mitenköhän Win10 (ja esim Blender?) tukee useampia kortteja?

1080 päivittyy 3080:ksi, mietin että 1080 tuskin saa ropoja enempää niin löytyykö mistään pro ohjelmasta (Blender, Adobe, RealityCapture ect) tukea useammalle kortillenykyäänvieläkään? Jos virtalähde antaisi periksi niin fantasioin että jättäisi molemmat koneeseen puksuttumaan..

Blender osaa hyödyntää ainakin cuda kortteja lähestulkoon lineaarisesti. Scenen kokoa rajoittaa pienimmällä VRAM määrällä oleva kortti.

seuraava pätkä on konkreettinen melko tuore (2080ti) blender testi noin puolen vuoden takaa.

- Liittynyt

- 13.09.2018

- Viestejä

- 810

Pidän 8K:ta monitoreissa täysin turhana. Sen ainoa tarkoitus on luoda uusi markkinoitava luokka, vaikka käytännön hyödyt niin televisioissa kuin monitoreissa ovat olemattomia.

Televisioissa koen sen turhana ellei asu jossain kartanossa jossa 77+ tuuman telkkarissa on jotain järkeäkin, mutta muuten etäisyys on yleensä sen verran iso, että 4K riittää vallan mainiosti.

Sen sijaan tietokonenäytössä 8K olisi vallan mainio. Pirun tarkka kuva työpöydällä, enemmän integer scaling mahdollisuuksia peleissä. 4K tai 1440p onnistuisi. Tuohon vielä DLSS kaveriksi ja yhtäkkiä 8K käyttäminen onkin ihan toimiva ratkaisu. Esim. ottaisin heti 8K version tästä nykyisestä LG CX 48" ruudusta.

- Liittynyt

- 14.02.2018

- Viestejä

- 212

Minulla on 27-tuumainen 4k-näyttö, ja käytin aiemmin töissä iMaciä, jossa on 27-tuumainen 5k-näyttö (5120x2880). Eron terävyydessä noiden näyttöjen välillä huomasi vielä selkeästi. iMacin pikselitiheydellä 8k-näyttö olisi 40,5-tuumainen, eikä tunnu mitenkään mahdottomalta ajatukselta, että sellainen olisi tässä työpöytänäyttönä. Pöytätilaa vain tarvitsisi vähän lisää.

- Liittynyt

- 09.09.2018

- Viestejä

- 360

Juu varmasti työkäytössä voi olla vaikka 16k resoluution monitori, mutta peleille kyllä aivan turhaa.

Ihan yhtä turhaa se pelailukin on, jos tuolle linjalle lähdetään.

no jos löydät fe kortteja vaikka msi.ltä niin kova juttu. löytyyköhän nvidian omalla tuuletinratkaisulla?Jatketaan nyt vielä tätä Off Topicia: Niin, siis se on väärin käytetty nimitys toki. Nuo AIB partnerit valmistavat tietenkin myös FE-kortteja, minkä takia AIB:n väittäminen viralliseksi termiksi ei olekaan enää niin virallinen, vaan ainostaan se tavallisesti väärin käytetty termi.

50 sixty ot.

Viimeksi muokattu:

- Liittynyt

- 14.10.2016

- Viestejä

- 24 533

Eivät valmista.Jatketaan nyt vielä tätä Off Topicia: Niin, siis se on väärin käytetty nimitys toki. Nuo AIB partnerit valmistavat tietenkin myös FE-kortteja, minkä takia AIB:n väittäminen viralliseksi termiksi ei olekaan enää niin virallinen, vaan ainostaan se tavallisesti väärin käytetty termi.

Valmistivat joskus aiemmin "referenssiversioita" ja sittemmin myös Founders Editioneita jotka olivat vain oman aikansa referenssiversioita, mutta nykyään RTX 20 -sarjasta lähtien NVIDIA on aloittanut kilpailemaan ihan suoraan AIB-valmistajia vastaan noille FE-korteillaan ja ne ovat ihan NVIDIAn oma yksinoikeustuote siinä missä vaikka Strix-mallit on Asuksen.

(toki NVIDIA edelleen valmistuttaa ne jollain ulkopuolisella valmistajalla, todennäköisesti Foxconnilla, mutta se on ihan normaalia eikä kaikki AIB-valmistajatkaan oikeasti valmista korttejaan itse)

no jos löydät fe kortteja vaikka msi.ltä niin kova juttu. löytyyköhän nvidian omalla tuuletinratkaisulla?

Toki löytyy:

MSI Global - The Leading Brand in High-end Gaming & Professional Creation

As a world leading gaming brand, MSI is the most trusted name in gaming and eSports. We stand by our principles of breakthroughs in design, and roll out the amazing gaming gear like motherboards, graphics cards, laptops and desktops.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 533

Niin, tuolloin Founders Edition oli vain hieno nimi referenssille. RTX 20 -sarjasta lähtien se on NVIDIAn oma korttisarja millä se kilpailee AIB-valmistajia vastaan eikä niitä myydä minkään muun merkin alla.Toki löytyy:

MSI Global - The Leading Brand in High-end Gaming & Professional Creation

As a world leading gaming brand, MSI is the most trusted name in gaming and eSports. We stand by our principles of breakthroughs in design, and roll out the amazing gaming gear like motherboards, graphics cards, laptops and desktops.www.msi.com

Eivät valmista.

Valmistivat joskus aiemmin "referenssiversioita" ja sittemmin myös Founders Editioneita jotka olivat vain oman aikansa referenssiversioita, mutta nykyään RTX 20 -sarjasta lähtien NVIDIA on aloittanut kilpailemaan ihan suoraan AIB-valmistajia vastaan noille FE-korteillaan ja ne ovat ihan NVIDIAn oma yksinoikeustuote siinä missä vaikka Strix-mallit on Asuksen.

(toki NVIDIA edelleen valmistuttaa ne jollain ulkopuolisella valmistajalla, todennäköisesti Foxconnilla, mutta se on ihan normaalia eikä kaikki AIB-valmistajatkaan oikeasti valmista korttejaan itse)

Joo, eivät varmasti valmista kaikkia ja kaikista malleista ja kaikki valmistajat eivät FE malleja tietenkään koskaan valmistakaan tai ole valmistaneetkaan. Pointti oli se, että AIB ei ole sama asia kuin custom.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 533

Eivät ole valmistaneet 10-sarjan jälkeen yhtään mistään eivätkä valmista ellei NVIDIA muuta tapojaan joskus tulevaisuudessa.Joo, eivät varmasti valmista kaikkia ja kaikista malleista ja kaikki valmistajat eivät FE malleja tietenkään koskaan valmistakaan tai ole valmistaneetkaan. Pointti oli se, että AIB ei ole sama asia kuin custom.

Käytännössä AIB-kortit ja customit ovat NVIDIAn kohdalla nykyään synonyymi, koska mitään referenssikortteja ei enää ole. AMD:n kohdalla ainakin vielä viime sukupolvessa voitiin erotella AIB-valmistajien custom-mallit ja refut, koska siellä oli edelleen referenssimalli mitä myös muut valmistivat/myivät.

Cirrus

Miksei maailma toimi asmilla?

- Liittynyt

- 16.10.2016

- Viestejä

- 3 377

2000:ssa fe:n piirilevy oli kuitenkin referenssi. Nyt 3000:ssa fe:n piirilevykin on oma eikä kellään muulla samaa.Niin, tuolloin Founders Edition oli vain hieno nimi referenssille. RTX 20 -sarjasta lähtien se on NVIDIAn oma korttisarja millä se kilpailee AIB-valmistajia vastaan eikä niitä myydä minkään muun merkin alla.

En vielä näkisi siis että kakstonnisella kilpailtiin täysiverisesti.

Blender osaa hyödyntää ainakin cuda kortteja lähestulkoon lineaarisesti. Scenen kokoa rajoittaa pienimmällä VRAM määrällä oleva kortti.

seuraava pätkä on konkreettinen melko tuore (2080ti) blender testi noin puolen vuoden takaa.

Pitääkin urkkia ja laskeskella tarkemmin!

Virtis on 780platinium ja hyvällä tuurilla se ehkä kestäisi sekä 3080 + 1080 (prossuna 5930k). Saisi tuon 1080 hyötykäyttöön..

Osaako kukan laskeskella lonkalta onko onnistumisen mahiksia vai huiteleeko jo liian riskirajoilla? 320w+180(?)+prossu 140w.

Setillä ajettu 970SLI:tä mutta nyt taitaa kyllä virtis natista?

- Liittynyt

- 21.06.2017

- Viestejä

- 7 535

Onko kellään teorioita siitä, että millä keinolla Nvidia puristaa 3070:stä vääntöä saman verran kuin 2080Ti:stä, kun tiitisessä on 37,5% enemmän muistikaistaa? Mahtaakohan olla kuinka tilanneriippuvaista noiden erot, kun balanssi shadereiden ja kaistan välillä on ihan totaalisesti erilainen?

Veikkaan että markkinointi on päästetty vauhtiin. Oli pressille ilmeisesti jaettu extra slideja joissa on 3070 vertailtu 2070 1440p resolla. En siis yllättyisi vaikka samalla resolla vertailu olisi "vahingossa" lipsahtanut myös tuota 2080Ti:tä vastaan jolloin ei ole mikään kovin suuri yllätys että tehot on about samat, varsinkin jos on sopivat pelit valittu että CPU pykii jo vastaan.

Isommat (48Gt) ja ehkä nopeemmatkin muistit voi tulla ensi vuonna, muuten en oikein keksi miten tosta voisi korottaa kun käyttävät jo lähes täyttä piiriä.

Tuon alle voi tulla jotain kyllä, esim. huhuttu 3080 20GB muistilla.

Veikkaampa että GA102 on 88SM:n siru. Nvidia on tykänny suunnitella noi piirit jo pitkään melko symmetriseen muotoon ja 82SM ei ole kovin hyvin jaollinen kun taas 88SM on esim 8:lla jos oletetaan että GA102 on suunnittelu noudattelee vaikka TU102:sta jossain määrin

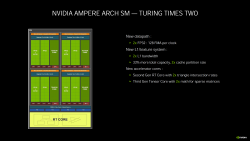

Sinällään jännä kun Turingin INT32 yksiköistä kertoessa Nvidian kaveri kertoili miten uudemmat / monimutkaisemmat pelit alkaa käyttää enemmän ja enemmän INT laskentaa. Nyt kuitenkin "tuplattiin" FP laskentateho.

Varmaankin taas markkinointi ollut vauhdissa. Jotenkinhan se pitää aina koittaa perustella että miksi on tehty jotakin miten on tehty. Jossain oli juttua että turingiin olisi jo haluttu tehdä tää sama cuda rakenne, mutta jouduttiin karsimaan koska siru olisi kasvanut niin isoksi ettei sitä olisi ollut järkevää enää valmistaa.

Ampere näköjään pystyy vaihtamaan int ja fp32 laskentaa tilanteen vaatiessa-- eli muuttamaan.

Siis esim. 3080:ssä on 4352 cudaa detikoitu FP32 laskentaa, aivan samoin kuten on 2080Ti:ssä, mutta nyt amperessa on toiset 4352 cudaa rinnalla jotka voivat laskea joko FP32 tai INT32 kun taas turingissa se rinnalla oleva kykeni ainoastaan INT32 laskentaan.

Eli jossain pelkässä FP32 kuormassa siinä 3080 on teorissa tuplasti ruutia verrattuna 2080Ti, mutta jos sinne työnnetään laskentaa jossa puolet on FP32 ja puolet on INT32 niin se 3080 käyttäytyy aivan samoin kuin 2080Ti.

Lisäksi siellä voi olla jossain muualla sellaisia pullonkauloja että toi tuplateho ei tule missään realisoitumaan. Eli tämäkin on mielestäni enemmänkin markkinoiti temppu kuin oikeasti mullistava asia.

Onhan sitä se peli perf mitä näkee nvidian doom 2080ti vs 3080 videosta tai digital foundryn videosta, plus rtx perf missä saattaa nähdä sen 100% hypyn vs 2080.

Kovin varovaisesti vielä henkseleitä paukuttelisin tuon 100% perf hypyn suhteen. Se voi jossain tilanteissa toteutua mutta realistisempi on varmaan joku 60-100% väliltä.

To

inenkin läytyy

vaikuttamassa kokonaissuoritukseen sillälailla että ei skaalaudu ihan 100%

Jätän tän tähän. Jos ei oo vielä postattu.

inenkin läytyy

Juu jäi sanomatta tuo osa että 8704 puolet on lennossa vaihtuvia int ja fp32 corea.Tämä on varmastiVeikkaan että markkinointi on päästetty vauhtiin. Oli pressille ilmeisesti jaettu extra slideja joissa on 3070 vertailtu 2070 1440p resolla. En siis yllättyisi vaikka samalla resolla vertailu olisi "vahingossa" lipsahtanut myös tuota 2080Ti:tä vastaan jolloin ei ole mikään kovin suuri yllätys että tehot on about samat, varsinkin jos on sopivat pelit valittu että CPU pykii jo vastaan.

Veikkaampa että GA102 on 88SM:n siru. Nvidia on tykänny suunnitella noi piirit jo pitkään melko symmetriseen muotoon ja 82SM ei ole kovin hyvin jaollinen kun taas 88SM on esim 8:lla jos oletetaan että GA102 on suunnittelu noudattelee vaikka TU102:sta jossain määrin

Varmaankin taas markkinointi ollut vauhdissa. Jotenkinhan se pitää aina koittaa perustella että miksi on tehty jotakin miten on tehty. Jossain oli juttua että turingiin olisi jo haluttu tehdä tää sama cuda rakenne, mutta jouduttiin karsimaan koska siru olisi kasvanut niin isoksi ettei sitä olisi ollut järkevää enää valmistaa.

Siis esim. 3080:ssä on 4352 cudaa detikoitu FP32 laskentaa, aivan samoin kuten on 2080Ti:ssä, mutta nyt amperessa on toiset 4352 cudaa rinnalla jotka voivat laskea joko FP32 tai INT32 kun taas turingissa se rinnalla oleva kykeni ainoastaan INT32 laskentaan.

Eli jossain pelkässä FP32 kuormassa siinä 3080 on teorissa tuplasti ruutia verrattuna 2080Ti, mutta jos sinne työnnetään laskentaa jossa puolet on FP32 ja puolet on INT32 niin se 3080 käyttäytyy aivan samoin kuin 2080Ti.

Lisäksi siellä voi olla jossain muualla sellaisia pullonkauloja että toi tuplateho ei tule missään realisoitumaan. Eli tämäkin on mielestäni enemmänkin markkinoiti temppu kuin oikeasti mullistava asia.

Kovin varovaisesti vielä henkseleitä paukuttelisin tuon 100% perf hypyn suhteen. Se voi jossain tilanteissa toteutua mutta realistisempi on varmaan joku 60-100% väliltä.

vaikuttamassa kokonaissuoritukseen sillälailla että ei skaalaudu ihan 100%

- Liittynyt

- 14.10.2016

- Viestejä

- 24 533

Ei ole, se on 84 SM:n siru joka on jaettu 7 GPC:een.Veikkaampa että GA102 on 88SM:n siru. Nvidia on tykänny suunnitella noi piirit jo pitkään melko symmetriseen muotoon ja 82SM ei ole kovin hyvin jaollinen kun taas 88SM on esim 8:lla jos oletetaan että GA102 on suunnittelu noudattelee vaikka TU102:sta jossain määrin

Charun

Tukijäsen

- Liittynyt

- 03.09.2018

- Viestejä

- 2 426

Tuossahan jo muut kerkes vastailemaankin, eli FE on Founders Edition, jota myy ja valmistuttaa pelkästään Nvidia tällä kierroksella. Referenssikortit on eri asia, joita myös AIB:t tekee/teettää Nvidian speksien mukaan ja sitten on tietysti vielä customit, joiden suunnittelu on sitten ihan oma taiteen lajinsa. Se, että aiemmin myös AIB:t on FE:tä (lähinnä siis nykyisen referenssikortin vastinetta) myyneet, ei tee tuosta toteamuksestani mitenkään faktuaalisesti väärää tämän nykyisen sukupolven kohdalla. Ajat muuttuu Eskoseni.FE on Founder's Edition ja AIB on Add in Board... FE on siis AIB, mutta AIB:lla tarkoitetaan tässä tapauksessa varmaan siis kustomoitua AIB:ta, joka poikkeaa nVidian alkuperäisestä FE AIB:stä?

Toki olisin voinut muotoilla tuon varmaan kymmenellä eri tavalla, mutta varmasti kaikki ymmärsi mitä tarkoitin FE vs. AIB, kun puhuttiin tuosta Nvidian jäähystä..?

Mutta jos nyt vielä rautalangasta, niin Nvidia on ainoa, joka 30-sarjasta FE kortteja valmistaa/teettää myyntiin. AIB:t sitten tekee joko referenssikortteja erilaisilla jäähdytysratkaisuilla, tai täysin custom design kortteja, joissa siis koko PCB leiska on "omaa käsialaa".

- Liittynyt

- 17.10.2016

- Viestejä

- 6 500

Veikkaampa että GA102 on 88SM:n siru. Nvidia on tykänny suunnitella noi piirit jo pitkään melko symmetriseen muotoon ja 82SM ei ole kovin hyvin jaollinen kun taas 88SM on esim 8:lla jos oletetaan että GA102 on suunnittelu noudattelee vaikka TU102:sta jossain määrin

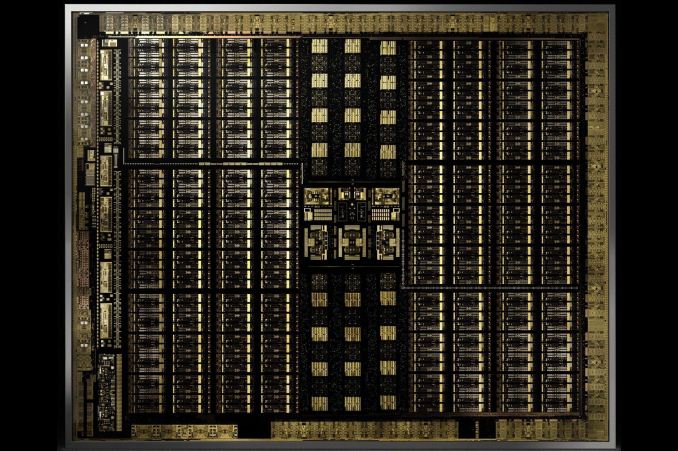

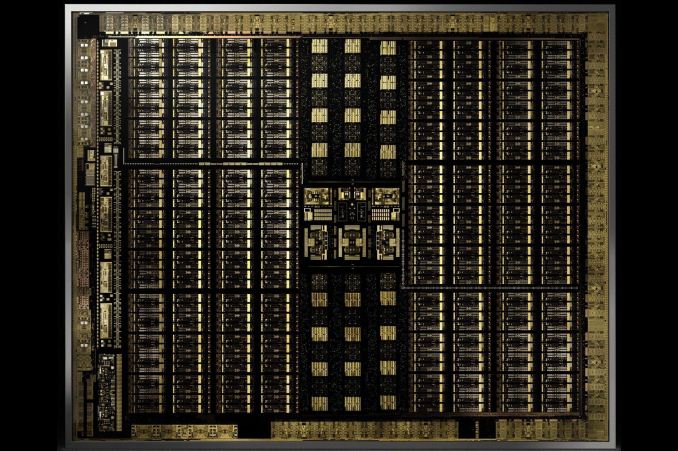

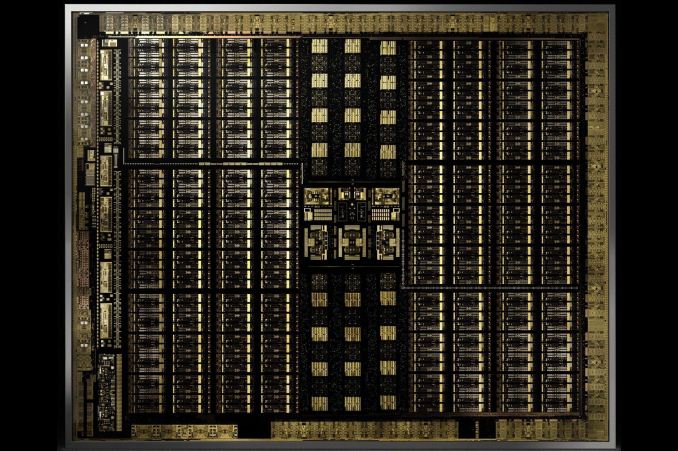

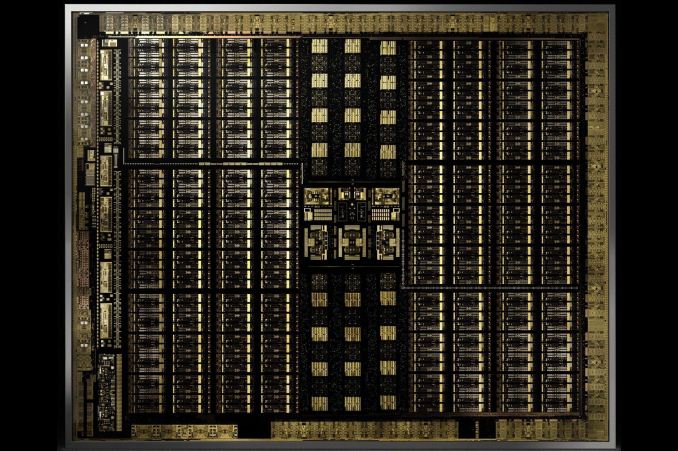

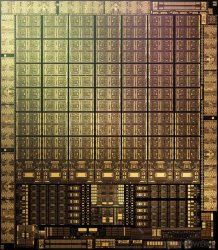

Koko piiri on tosiaan 84 SM ja on ihan laskettavissa piirin kuvasta (7x12=84, lähde TPU, jossa myös block diagram kuva NVIDIA GA102 GPU Specs):Ei ole, se on 84 SM:n siru joka on jaettu 7 GPC:een.

Edit: Näköjään sama piirin kuva ihan Nvidian omillakin sivuilla, mutta pienempänä NVIDIA GeForce -näytönohjaimet

Edit2: Niin, 3090 tosiaan on 10496 CUDA ydintä, kun taas 84 SM tarkoittaa 10752 (84x128, TPU:n linkin SM diagrammista voi laskea tarvittaessa yhden SM yksikön FP32 yksiköt). Täten 3090Ti/Super/Titan RTX2 lienee mahdollinen, mutta melko vaatimattomalla tehoerolla.

Viimeksi muokattu:

- Liittynyt

- 24.06.2019

- Viestejä

- 523

Kysymyksenä siellä @JosseTheRedman oli myös, että kuinka pitkään FE-kortteja on tehdään myytäväksi. Osaako tähän joku vastata aiemmista sarjoista osviittaa? Kiinnostaisi itseäkin.

Toinen kyssäri kun en Turingin julkaisua seurannut pätkääkään, niin muistatteko oliko hypetys silloinkin vastaavalla tasolla vai selvisikö heti julkkarissa ja huhuissa, että parannukset Pascaliin nähden ovat vaisuhkoja?

Toinen kyssäri kun en Turingin julkaisua seurannut pätkääkään, niin muistatteko oliko hypetys silloinkin vastaavalla tasolla vai selvisikö heti julkkarissa ja huhuissa, että parannukset Pascaliin nähden ovat vaisuhkoja?

- Liittynyt

- 21.06.2017

- Viestejä

- 7 535

Koko piiri on tosiaan 84 SM ja on ihan laskettavissa piirin kuvasta (7x12=84, lähde TPU, jossa myös block diagram kuva NVIDIA GA102 GPU Specs):

Oke, ittellä ei ollu tiedossa että siitä on jo kuva tullut.

- Liittynyt

- 19.10.2016

- Viestejä

- 3 784

Osaako joku kertoa että kuinka paljon nykypeleissä käytetään FP32 ja INT32 laskentaa jotta saisi kuvan että paljonko sitä INT32 laskentaa tarvitaan ja paljonko on hyötyä tuosta 2xFP32 laskennasta siis silloin kun INT32 laskentaa ei ole ollenkaan.

Edit. Ja kai tuota amperea voi käyttää esim. niin että vaikka 90% FP32 laskentaa ja 10% INT32 tai ainakin siihen min 50/50% asti? Sorry oon pihalla näistä kuin lumiukko.

Edit2. Löysin tällaisen videon turing arkkitehtuurista ja kai nykypelit käyttävät ainakin jossain määrin INT32 laskentaa joten suorituskyky peleissä voi olla vaihtelevaa(tietenkin)

Ampere teksteistä tällaista.

"Doubling the processing speed for FP32 improves performance for a number of common graphics and compute operations and algorithms. Modern shader workloads typically have a mixture of FP32 arithmetic instructions such as FFMA, floating-point additions (FADD), or floating-point multiplications (FMUL), combined with simpler instructions such as integer adds for addressing and fetching data, floating-point compare, or min/max for processing results, etc. Performance gains will vary at the shader and application level depending on the mix of instructions. Ray tracing denoising shaders are good examples that might benefit greatly from doubling FP32 throughput. "

Edit. Ja kai tuota amperea voi käyttää esim. niin että vaikka 90% FP32 laskentaa ja 10% INT32 tai ainakin siihen min 50/50% asti? Sorry oon pihalla näistä kuin lumiukko.

Edit2. Löysin tällaisen videon turing arkkitehtuurista ja kai nykypelit käyttävät ainakin jossain määrin INT32 laskentaa joten suorituskyky peleissä voi olla vaihtelevaa(tietenkin)

Ampere teksteistä tällaista.

"Doubling the processing speed for FP32 improves performance for a number of common graphics and compute operations and algorithms. Modern shader workloads typically have a mixture of FP32 arithmetic instructions such as FFMA, floating-point additions (FADD), or floating-point multiplications (FMUL), combined with simpler instructions such as integer adds for addressing and fetching data, floating-point compare, or min/max for processing results, etc. Performance gains will vary at the shader and application level depending on the mix of instructions. Ray tracing denoising shaders are good examples that might benefit greatly from doubling FP32 throughput. "

Viimeksi muokattu:

- Liittynyt

- 14.10.2016

- Viestejä

- 24 533

Riippuu ihan sovelluksesta, Turingin julkaisun aikaan NVIDIA oli sitä mieltä että noin kolmannes olisi INT-laskuja. FP-yksiköt voivat kyllä laskea niitäkin, mutta niiden pitää lopettaa siksi aikaa FP-hommien teko. Turingissa NVIDIA lisäsi SM-yksikköön toisen erillisen datapolun INT-käskyille ja laskuyksiköt siihen kaveriksi. Amperessa on edelleen kaksi erillistä datapolkua, mutta nyt kumpikin polku voi suorittaa FP-laskuja kun ei ole INT-hommia ja kun on, vain toinen datapolku joutuu lopettamaan FP-laskut INT-laskujen ajaksi. Tarkempia detaileja saadaan kun NVIDIA julkaisee Amperen whitepaperit.Osaako joku kertoa että kuinka paljon nykypeleissä käytetään FP32 ja INT32 laskentaa jotta saisi kuvan että paljonko sitä INT32 laskentaa tarvitaan ja paljonko on hyötyä tuosta 2xFP32 laskennasta.

Kaksi FP32-yksikköä teoriassa kaksinkertaistaa laskentakyvyn kunhan niitä saadaan ruokittua tarpeeksi.

Alustavien testien perusteella vaikuttaa siltä että siellä on suht massiivisia pullonkauloja muualla, kun 3080:ssa on teoreettisesti liki 3x laskentavoimaa vrt 2080S, mutta suorituskyky paranee NVIDIAn itse valkkaamissakin testeissä vain 60-80%

- Liittynyt

- 17.10.2016

- Viestejä

- 6 500

Vain puolet ovat FP32/INT32 ja puolet pelkkiä FP32. Alla vielä kuva SM:n rakenteesta ja lisää voi lukea esim. NVIDIA GeForce RTX 30 Ampere GPU Deep-Dive, Full Specs, Thermals, Power & Performance Detailed (whitepaper julkaistaan 17. päivä)Siis pystyykö amperen kaikki shaderit laskemaan FP32/INT32 laskuja(ei tietenkään samaan aikaan) vai kun minulle jäi sellainen käsitys että 50% on varattu pelkkään FP32 ja loput 50% FP32/INT32? Olenko väärässä? En tiedä mistä jäi tuollainen päähän.

Edit:

Kieltämättä mielenkiintoinen huomio, sillä raa'assa FP32 suorituskyvyssä teoreettisesti 3080 olisi ~183% tehokkaampi (8704 vs 3072 CUDA) kuin 2080S ja muistikaistaa löytyy ~53% enemmän (760GB/s vs 496GB/s). Puhtaalla INT32+FP32 kuormalla ero olisi ~42% (4352 vs 3072 CUDA) ja sama ~53%.Alustavien testien perusteella vaikuttaa siltä että siellä on suht massiivisia pullonkauloja muualla, kun 3080:ssa on teoreettisesti liki 3x laskentavoimaa vrt 2080S, mutta suorituskyky paranee NVIDIAn itse valkkaamissakin testeissä vain 60-80%

Digital Foundryn alustavien testien perusteella voitaneen siis päätellä, että kuorma olisi jo melko pitkälti INT32+FP32 (?) ja uuden 6X muistin uudistusten etu sitten vaikuttaa jotenkin.

Viimeksi muokattu:

- Liittynyt

- 13.12.2016

- Viestejä

- 5 437

Toinen kyssäri kun en Turingin julkaisua seurannut pätkääkään, niin muistatteko oliko hypetys silloinkin vastaavalla tasolla vai selvisikö heti julkkarissa ja huhuissa, että parannukset Pascaliin nähden ovat vaisuhkoja?

Ei todellakaan ollut hypeä Turingin julkkarin jälkeen. Iso pettymys erinomaisen 1000 sarjan jälkeen. 2080 oli tasoissa 1080Ti:n kanssa, ja 20 pinnaa nopeampi 2080Ti maksoi 1200€. RTX ominaisuuksista ei ollut käytännössä mitään iloa kuukausiin.

Tuossa launch tilaisuudessa tosin keskityttiin ainoastaan Ray Tracingin hehkutukseen, ja normi rasterointisuorituskyvystä ei taidettu puhia oikeastaan mitään...

Videocardz.com--- rtx3080 performance 168% vs 2080 in cuda and opencl benchmarks.

40% vs 2080ti

jaaha....

NVIDIA GeForce RTX 3080: 168% of RTX 2080 SUPER performance in CUDA and OpenCL benchmarks - VideoCardz.com

The first post-announcement benchmark of the GeForce RTX 3080 graphics cards. NVIDIA GeForce RTX 3080: 168% of RTX 2080 performance The GeForce RTX 3080 has been put through a number of CUDA and OpenCL tests with the Compubench benchmark suite. The GeForce RTX 3080 graphics card has been tested...

The RTX 3080 has on average 168% of RTX 2080 SUPER performance and 138-141% performance of the RTX 2080 Ti.

- Liittynyt

- 22.10.2016

- Viestejä

- 12 621

8K alkaa olemaan muutenki jo sellainen resoluutio monitoreille, että kuka tuota tarvitsee, täytyy olla joku vähintään 100" ruutu kotona että noista pikseleistä hyötyy...

Niinpä.

Edellisessä työpaikassa tuli katseltua todella isoja datariippuvuusgraafeja, joita kääntäjäni sisäisesti käytti, yrittäen itseä sieltä jotain ylimääräistä tai puuttuvaa kaarta kun kääntäjä bugasi. Niitä olisi kiva ollut katsella jostain koko seinän/flappitaulun kokoiselta ruudulta 8k-resolla

Ja "Ultrawidet" on vaan "ultramatalia".

Tuo 4C4T on ollut pullonkaulana jo vuosia. Muistan kun joskus kolmisen vuotta sitten päivitin lähelle 5Ghz ylikellotetusta Intelin 4C4T prosessorista AMD:n 8-ytimiseen ja jopa silloisella GTX970 näytönohjaimella ero oli peleissä suuri. Tuskin nykyään edes on niin huonoja näytönohjaimia, missä tuollainen prosessori ei hidastaisi menoa.

Riippuu ihan pelistä. 4c prossu olisi ihan hyvä olla noissa testeissä. Tuon coremäärän suhteen kun on keulittu paljon täysin turhaan..

- Liittynyt

- 26.10.2016

- Viestejä

- 7 652

Niinpä.

Edellisessä työpaikassa tuli katseltua todella isoja datariippuvuusgraafeja, joita kääntäjäni sisäisesti käytti, yrittäen itseä sieltä jotain ylimääräistä tai puuttuvaa kaarta kun kääntäjä bugasi. Niitä olisi kiva ollut katsella jostain koko seinän/flappitaulun kokoiselta ruudulta 8k-resolla

Ja "Ultrawidet" on vaan "ultramatalia".

Joo joku 8:3 suhde voisi olla kivempi, jos mennään noista 32:9 vähän korkeammaksi.

- Liittynyt

- 23.10.2016

- Viestejä

- 1 250

Kannataako muuten välttää tilaamista Nvidian EU-sivustolta? Redditistä olen pari kauhutarinaa lukenut että RMA-prosessi yhtä helvettiä ja lähettävät näytönohjaimet melkein kokonaan ilman pehmustetta euroopasta.

Tuo 3070 FE- referenssi kiihottaisi, mutta taitaa ainoa paikka saada tuo niin suoraan Nvidialta(?)

Tuo 3070 FE- referenssi kiihottaisi, mutta taitaa ainoa paikka saada tuo niin suoraan Nvidialta(?)

- Liittynyt

- 31.12.2016

- Viestejä

- 775

Kannataako muuten välttää tilaamista Nvidian EU-sivustolta? Redditistä olen pari kauhutarinaa lukenut että RMA-prosessi yhtä helvettiä ja lähettävät näytönohjaimet melkein kokonaan ilman pehmustetta euroopasta.

Tuo 3070 FE- referenssi kiihottaisi, mutta taitaa ainoa paikka saada tuo niin suoraan Nvidialta(?)

Aikoinaan 2080 tuli tuolta tilattua, ja pelkkä paperipaketti oli lähetyspakettina ilman pehmusteita. Kortti tuli kuitenkin täysin ehjänä perille, eikä alkuperäispakkauksessakaan ollut mitään jälkiä. RMA prosessit on monesti haastavia, kun mennään ulkomaille mutta kyseisestä ei ole omakohtaista kokemusta.

Itsellä ei siis sinällään ollut mitään ongelmaa Nvidian EU -kaupasta, enkä ole kuullut mitään sen kummempaa pahaa parilta tutultakaan, jotka on sieltä tilannut.

Näyttäisi ainakin hyvältä. Tosin saa nähdä uskaltaako kukaan mitään julkaista ennen 14.9., toisaalta viikon päässä enää sekin....Jokohan ensinmäiset revikat kohta valuisi?

Veikkaan, ettei noin tunnettu sivusto ala kikkailemaan, jos ei lupaa ole.Näyttäisi ainakin hyvältä. Tosin saa nähdä uskaltaako kukaan mitään julkaista ennen 14.9., toisaalta viikon päässä enää sekin....

Juu samaa mieltä.Veikkan, ettei noin tunnettu sivusto ala kikkailemaan, jos ei lupaa ole.

Olikos niin että 14.9. saa puhua myös 3090 ja 3070 malleista? Vai koskiko tuo vain 3080?

Uutiset

-

io-tech toivottaa rauhallista joulua 2025!

24.12.2025 13:34

-

Uusi artikkeli: Testissä Samsung Galaxy S25 FE

24.12.2025 01:18

-

Samsung julkaisi ensimmäisen aallon Odyssey 2026 -näyttömallistosta

23.12.2025 23:00

-

NVIDIA julkaisi uudet GeForce 591.59 -ajurit näytönohjaimilleen

23.12.2025 18:30

-

Samsung julkaisi maailman ensimmäisen 2 nanometrin mobiilijärjestelmäpiirin: Exynos 2600

22.12.2025 21:09

Uusimmat viestit

-

-

-

Samsung julkaisi ensimmäisen aallon Odyssey 2026 -näyttömallistosta

- Viimeisin: ratkakapu

-

-