finWeazel

Tukijäsen

- Liittynyt

- 15.12.2019

- Viestejä

- 12 720

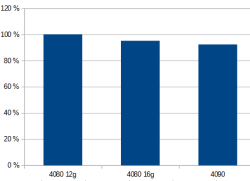

Hienosti hermanni. Meinaatkos että mamma ja pappa jotka ostaa villepetterille konneen ku on toivottu että siinä o vaikka rtx4080 ni tietää eron 16gb ja 12gb välillä? Toi on ihan suoraan kuluttajan harhauttamista tuo nimeäminen ja itsekkin tiedät sen.

Jos ostaa sian säkissä niin saa sian säkissä, tai ehkä hermannin. Ton hintaluokan vehkeissä kannattaa kyllä ne arvostelut tsekata ennen ostamista. Tai sit on niin paljon ylimääräistä rahaa ettei vaan kiinnosta ja mulla olis niitä taikapapuja tonnin kipale myynnissä.